OpenAI беше на прага на нов преломен момент. Стартъпът завърши първоначален кръг от обучение през септември за масивен нов модел на изкуствен интелект, който се надяваше значително да надмине предишните версии на технологията зад ChatGPT и да се доближи до целта си за мощен AI, който да превъзхожда хората.

Но моделът, известен вътрешно като Orion, не е постигнал желаното представяне от компанията, според двама души, запознати с въпроса, които са говорили при условие за анонимност, защото обсъжданите въпроси не са публични. Orion все още не успява да отговори на въпроси за кодиране, на които не е бил обучен, казаха лицата. Като цяло Orion засега не се счита за толкова голяма стъпка напред от съществуващите модели на OpenAI, колкото GPT-4 беше от GPT-3.5, системата, която първоначално захранваше водещия чатбот на компанията, казаха източниците.

OpenAI не е единствената, която в последно време среща препъни камъни. След като години наред пускаха все по-сложни AI продукти с главоломна скорост, три от водещите AI компании сега отчитат намаляваща възвръщаемост от скъпите си усилия за изграждане на по-нови модели.

В Google на Alphabet Inc. предстоящата итерация на софтуера Gemini не отговаря на вътрешните очаквания, според трима души, запознати с въпроса. Междувременно Anthropic ще пропусне графика за пускането на своя дългоочакван модел Claude, наречен 3.5 Opus.

Компаниите са изправени пред няколко предизвикателства. Става все по-трудно да се намерят нови, неизползвани източници на висококачествени, създадени от човека данни за обучение, които могат да се използват за изграждане на по-напреднали AI системи. Незадоволителното кодиране на Orion се дължи отчасти на липсата на достатъчно данни за кодиране, върху които да се тренира, казаха двама източници. В същото време дори скромните подобрения може да не са достатъчни, за да оправдаят огромните разходи, свързани с изграждането и експлоатацията на нови модели, или да отговорят на очакванията, които идват с брандирането на продукт като основно надграждане.

Има много потенциал да направим тези модели по-добри. Според един от източниците OpenAI подлага Orion на продължил месеци процес, често наричан последващо обучение. Тази процедура, която е рутинна, преди една компания да пусне публично нов софтуер за изкуствен интелект, включва включване на човешка обратна връзка за подобряване на отговорите и прецизиране на тона за това как моделът трябва да взаимодейства с потребителите, наред с други неща. Но Orion все още не е на нивото, което OpenAI би искала, за да го пусне на потребителите, и компанията едва ли ще пусне системата до началото на следващата година, каза един източник.

Тези проблеми предизвикват неписаните закони, които се наложиха в Силициевата долина през последните години, особено след като OpenAI пусна ChatGPT преди две години. Голяма част от технологичната индустрия заложи на така наречените закони за мащабиране, според които повече изчислителна мощност, данни и по-големи модели неизбежно ще проправят пътя за по-големи скокове напред в силата на AI.

Неотдавнашните неуспехи също пораждат съмнения относно огромните инвестиции в AI и осъществимостта на постигането на основна цел, която тези компании преследват агресивно: изкуствен общ интелект (AGI). Терминът обикновено се отнася до хипотетични AI системи, които биха съвпаднали или надхвърлили хората по много интелектуални задачи. Главните изпълнителни директори на OpenAI и Anthropic по-рано казваха, че AGI може да е реалност само след няколко години.

„Балонът на AGI започва да издиша“, каза Маргарет Мичъл, главен учен по етика в стартиращата компания за изкуствен интелект Hugging Face. Стана ясно, каза тя, че може да са необходими „различни подходи за обучение“, за да могат AI моделите да работят наистина добре при различни задачи – идея, която редица експерти по изкуствен интелект изразиха пред Bloomberg News.

В изявление говорител на Google DeepMind каза, че компанията е „доволна от напредъка, който виждаме при Gemini, и ще споделим повече, когато сме готови“. OpenAI отказа коментар. Anthropic отказа коментар, но препрати Bloomberg News към петчасов подкаст с участието на главния изпълнителен директор Дарио Амодей, който беше пуснат в понеделник.

„Хората ги наричат закони за мащабиране. Това е погрешно наименование“, казва той в подкаста. „Те не са закони на Вселената. Те са емпирични закономерности. Ще заложа в полза на това, че ще продължат да действат, но не съм сигурен в това."

Амодей казва, че има „много неща“, които биха могли да „дерайлират“ процеса за достигане на по-мощен AI през следващите няколко години, включително възможността „да останем без данни“. Но добавя, че е оптимистично настроен, че компаниите за изкуствен интелект ще намерят начин да преодолеят всякакви препятствия.

Плато

Технологията, която е в основата на ChatGPT и вълната от съперничещи AI чатботове, е изградена върху набор от публикации в социалните медии, онлайн коментари, книги и други данни, свободно извлечени от цялата мрежа. Това беше достатъчно, за да се създадат продукти, които могат да бълват умни есета и стихотворения, но изграждането на AI системи, които са по-умни от Нобелов лауреат – както се надяват да направят някои компании – може да изисква източници на данни, различни от публикации в Wikipedia и субтитри в YouTube.

OpenAI, по-специално, сключи сделки с издатели, за да задоволи част от нуждата от висококачествени данни и също така да се адаптира към нарастващия правен натиск от страна на издатели и творци върху данните, използвани за изграждане на генеративни AI продукти. Някои технологични компании също наемат хора с висше образование, които могат да етикетират данни, свързани с техния собствен предметен опит, като математика и кодиране. Целта е да направим тези системи по-добри в отговарянето на запитвания по определени теми.

Тези усилия са по-бавни и по-скъпи от простото изсмукване на данни от мрежата. Технологичните компании също се обръщат към синтетични данни, като например компютърно генерирани изображения или текст, предназначени да имитират съдържание, създадено от реални хора. Но и тук има граници.

„Става въпрос по-малко за количеството, а повече за качеството и разнообразието на данните“, каза Лила Третиков, ръководител на стратегията за AI в New Enterprise Associates и бивш заместник-главен технологичен директор в Microsoft. „Можем да генерираме количество синтетично, но е трудно да получим уникални, висококачествени набори от данни без човешко ръководство, особено що се отнася до езика.“

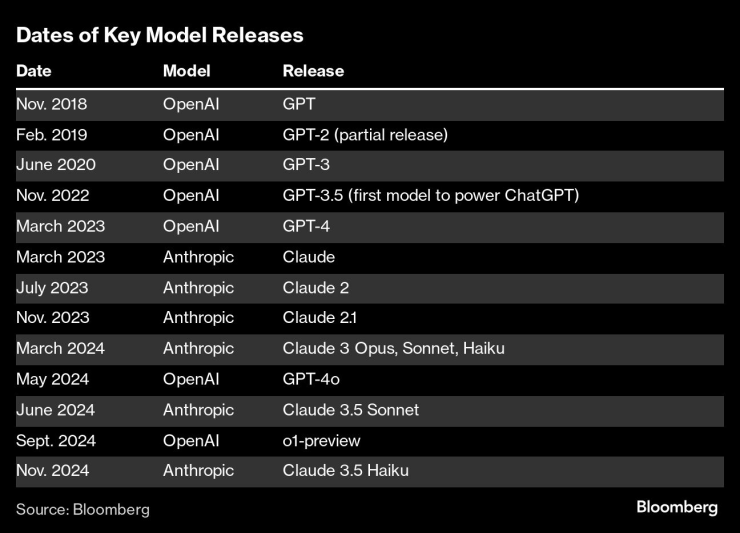

Дати на пускане на ключови модели

И все пак компаниите, занимаващи се с изкуствен интелект, продължават да следват принципа „повече е по-добре“. В стремежа си да създадат продукти, които се доближават до нивото на човешкия интелект, технологичните фирми увеличават количеството изчислителна мощност, данни и време, което използват за обучение на нови модели - и повишават разходите в процеса. Амодей каза, че компаниите ще похарчат 100 милиона долара за обучение на съвременен модел тази година и тази сума ще достигне 100 милиарда долара през следващите години.

С нарастването на разходите нарастват и залозите и очакванията за всеки нов модел в процес на разработка. Ноа Гиансиракуза, доцент по математика в университета Бентли в Уолтъм, Масачузетс, каза, че моделите на AI ще продължат да се подобряват, но скоростта, с която това ще се случи, е под въпрос.

„Бяхме много развълнувани за кратък период на много бърз напредък“, каза той. „Това просто не беше устойчиво.“

Проблемът пред Силициевата долина

Тази главоблъсканица стана обект на внимание през последните месеци в Силициевата долина. През март Anthropic пусна комплект от три нови модела и каза, че най-мощната опция, наречена Claude Opus, превъзхожда GPT-4 на OpenAI и системите Gemini на Google по ключови показатели, като разсъждения и кодиране на ниво висше образование.

През следващите няколко месеца Anthropic пусна актуализации на другите два модела Claude – но не и Opus. „Това беше нещото, от което всички се вълнуваха“, каза Саймън Уилисън, независим изследовател на AI. До октомври Уилисън и други наблюдатели на индустрията забелязаха, че формулировката, свързана с 3.5 Opus, включително индикация, че ще пристигне „по-късно тази година“ и „идва скоро“, е премахната от някои страници на уебсайта на компанията.

Подобно на своите конкуренти, Anthropic е изправенa пред предизвикателства зад кулисите, за да разработи 3.5 Opus, според двама души, запознати с въпроса. След като го обучи, Anthropic установи, че 3.5 Opus се представя по-добре при оценките от по-старата версия, но не толкова, колкото би трябвало, като се има предвид размерът на модела и колко скъпо беше изграждането и поддръжката му, каза един от хората.

Говорител на Anthropic каза, че датата за пускането на Opus е премахната от уебсайта като част от маркетингово решение да се показват само налични модели. Запитан дали Opus 3.5 все пак ще излезе тази година, говорителят посочи забележките на Амодей в подкаста. В интервюто изпълнителният директор каза, че Anthropic все още планира да пусне модела, но многократно отказа да се ангажира с график.

Технологичните компании също започват да се чудят дали да продължат да предлагат по-старите си AI модели, може би с някои допълнителни подобрения, или да поемат разходите за поддръжка на изключително скъпи нови версии, които може да не се представят много по-добре.

Google пусна актуализации на своя водещ AI модел Gemini, за да го направи по-полезен, включително възстановяване на способността за генериране на изображения на хора, но въведе малко големи новости в качеството на основния модел. Междувременно OpenAI се съсредоточи върху редица сравнително постепенни актуализации тази година, като например нова версия на функция за гласов асистент, която подобрява качеството на разговорите с ChatGPT.

Съвсем наскоро OpenAI пусна предварителна версия на модел, наречен o1, който прекарва допълнително време в изчисляване на отговор, преди да отговори на запитване, процес, който компанията нарича "разсъждение". Google работи върху подобен подход, с цел да обработва по-сложни заявки и да дава по-добри отговори с течение на времето.

Технологичните фирми също са изправени пред значителни компромиси с отклоняването на твърде много от желаните им компютърни ресурси към разработване и управление на по-големи модели, които може да не са значително по-добри.

„Всички тези модели станаха доста сложни и не можем да доставяме толкова много неща паралелно, колкото бихме искали“, написа изпълнителният директор на OpenAI Сам Алтман в отговор на въпрос в скорошна сесия на Ask Me Anything в Reddit. Създателят на ChatGPT е изправен пред „много ограничения и трудни решения“, каза той, за това как решава какво да прави с наличната си изчислителна мощност.

Алтман каза, че OpenAI ще има някои „много добри версии“ по-късно тази година, но този списък няма да включва GPT-5 – име, което мнозина в AI индустрията биха очаквали компанията да използва за нов важен модел след GPT-4, който беше въведен преди повече от 18 месеца.

Подобно на Google и Anthropic, OpenAI сега пренасочва вниманието от размера на тези модели към разширяване на употребата им, включително набор от AI инструменти, наречени агенти, които могат да резервират полети или да изпращат имейли от името на потребителя. „Ще имаме все по-добри и по-добри модели“, написа Алтман в Reddit. „Но мисля, че нещото, което ще се почувства като следващия гигантски пробив, ще бъдат агентите.“

Още по темата

- 1 Чиповете на Nvidia не трябва да присъстват на масата за преговори

- 2 Треска за злато в Китай след ескалацията на търговската война със САЩ

- 3 След промените на Тръмп „полицаите от Wall Street са премахнати“, твърди Уорън

- 4 САЩ са готови да признаят Крим за руски в рамките на сделката за Украйна

- 5 Макрон с призив за привличане във Франция на учени, подложени на натиск в САЩ

Клуб Investor с Ивайло Лаков /п./

Клуб Investor с Ивайло Лаков /п./

Кои са най-надеждните автомобили?

Кои са най-надеждните автомобили?  Вкусно: Идея за Тирамису с остатъците от козунак след Великден

Вкусно: Идея за Тирамису с остатъците от козунак след Великден  Революция в интернет: Китай стартира първата 10G мрежа

Революция в интернет: Китай стартира първата 10G мрежа  Защо е важно обикалянето около църквите на Великден?

Защо е важно обикалянето около църквите на Великден?

Руски самолети са били прихванати близо до въздушното пространство на НАТО

Руски самолети са били прихванати близо до въздушното пространство на НАТО  Традиция за Великден: Две съперничещи си църкви водят „ракетна война“ една срещу друга ВИДЕО

Традиция за Великден: Две съперничещи си църкви водят „ракетна война“ една срещу друга ВИДЕО  Карлос Насар: Режимът "Хищник" е чувството, което изпитвам, когато стъпя на състезание

Карлос Насар: Режимът "Хищник" е чувството, което изпитвам, когато стъпя на състезание  Не само Мъск иска легион от деца, кои са другите фанатици?

Не само Мъск иска легион от деца, кои са другите фанатици?

Още двама големи играчи напуснаха световното по снукър

Още двама големи играчи напуснаха световното по снукър  Стюардите обясниха наказанието на Макс, дори са го пожалили

Стюардите обясниха наказанието на Макс, дори са го пожалили  Бостън се разправи с Орландо след почивката

Бостън се разправи с Орландо след почивката  Гръмотевиците се стовариха брутално върху Гризлис

Гръмотевиците се стовариха брутално върху Гризлис

Кои са градовете с най-мръсен въздух в Европа?

Кои са градовете с най-мръсен въздух в Европа?  10 автомобила, които лесно ще изкарат повече от 20 години

10 автомобила, които лесно ще изкарат повече от 20 години  10 факта за автомобилите, които си мислите, че знаете, но дали е така?

10 факта за автомобилите, които си мислите, че знаете, но дали е така?  Subaru направи въздушна възглавница за защита на велосипедистите

Subaru направи въздушна възглавница за защита на велосипедистите

продава, Четиристаен апартамент, 105 m2 Пазарджик област, гр.Велинград, 158550 EUR

продава, Четиристаен апартамент, 105 m2 Пазарджик област, гр.Велинград, 158550 EUR  продава, Четиристаен апартамент, 108 m2 Пазарджик област, гр.Велинград, 162000 EUR

продава, Четиристаен апартамент, 108 m2 Пазарджик област, гр.Велинград, 162000 EUR  продава, Къща, 312 m2 Пазарджик област, гр.Велинград, 475555 EUR

продава, Къща, 312 m2 Пазарджик област, гр.Велинград, 475555 EUR  продава, Парцел, 845 m2 Варна, м-т Прибой, 132000 EUR

продава, Парцел, 845 m2 Варна, м-т Прибой, 132000 EUR  продава, Къща, 165 m2 Варна, м-т Боровец - юг, 151000 EUR

продава, Къща, 165 m2 Варна, м-т Боровец - юг, 151000 EUR