Много компании казват, че облакът е нещото, което използват, когато става въпрос за обучение и изпълнение на големи AI приложения, но днес само малка част от съществуващата облачна инфраструктура всъщност е настроена да поддържа това. Останалата не е.

Сега облачните доставчици, включително Amazon Web Services, Microsoft Azure и Google Cloud, са подложени на натиск да променят това положение, за да отговорят на изчислителните изисквания на големия бум на AI – докато други доставчици на хардуер виждат потенциална възможност за влизане на пазара, пише The Wall Street Journal.

„В момента има доста голям дисбаланс между търсенето и предлагането“, каза Четан Капур, директор продуктов мениджмънт в отдела Elastic Compute Cloud на Amazon Web Services.

Повечето генеративни AI модели днес са обучени и работят в облака. Тези модели, предназначени да генерират оригинален текст и анализ, могат да бъдат от 10 пъти до 100 пъти по-големи от по-старите AI модели, каза Зиад Асгар, старши вицепрезидент по управление на продукти в Qualcomm Technologies, добавяйки, че броят на случаите на употреба и броят на потребителите нарастват експлозивно.

„Има ненаситно търсене“ за големи езикови модели в момента, включително в индустриални сектори като производство и финанси, каза Ниди Чапел, генерален мениджър на Azure AI Infrastructure.

Това оказва по-голям натиск от всякога върху ограничено количество изчислителен капацитет, който разчита на още по-ограничен брой специализирани чипове като графични чипове или графични процесори от Nvidia. Компании като Johnson & Johnson, Visa, Chevron и други заявиха, че очакват да използват облачни доставчици за AI услуги.

Но голяма част от инфраструктурата не е изградена за работа с толкова големи и сложни системи. Облакът се рекламираше като удобен заместител на локални сървъри, който може лесно да увеличава и намалява капацитета с модел на ценообразуване на разплащане. Голяма част от днешния облачен отпечатък се състои от сървъри, проектирани да изпълняват множество работни натоварвания едновременно, които използват процесорни чипове с общо предназначение.

Според анализаторите малка част от него работи на чипове, оптимизирани за AI, като GPU и сървъри, проектирани да функционират в съвместни клъстери, за да поддържат по-големи натоварвания, включително големи AI модели. Графичните процесори са по-добри за AI, тъй като могат да обработват много изчисления наведнъж, докато централните процесори (CPU) обработват по-малко изчисления едновременно.

В AWS един клъстер може да съдържа до 20 000 GPU. Оптимизираната за AI инфраструктура е малък процент от общия облачен отпечатък на компанията, каза Капур, но расте с много по-бързи темпове. Той каза, че компанията планира да внедри множество оптимизирани за AI сървърни клъстери през следващите 12 месеца.

Microsoft Azure и Google Cloud Platform заявиха, че работят по подобен начин, за да превърнат AI инфраструктурата в по-голяма част от общия си флот. Чапел от Microsoft обаче каза, че това не означава, че компанията непременно се отдалечава от споделения сървър - изчисления с общо предназначение - който все още е ценен за компаниите.

Други доставчици на хардуер имат възможност да играят в този пазар, каза Лий Сустар, главен анализатор в технологичната изследователска и консултантска фирма Forrester.

Dell Technologies очаква, че високите разходи за облачни услуги, свързани с интензивна употреба, включително модели за обучение, могат да накарат някои компании да обмислят локално внедряване. Производителят на компютри има сървър, предназначен за тази употреба.

Облачните доставчици твърдят, че разполагат с няколко предложения на различни цени и че в дългосрочен план локалните внедрявания могат да се окажат по-скъпи, тъй като предприятията ще трябва да направят огромни инвестиции, когато искат да надстроят хардуера.

Qualcomm каза, че в някои случаи може да е по-евтино и по-бързо за компаниите да управляват модели на отделни устройства, като по този начин се намали натиска върху облака. В момента компанията работи за оборудването на устройства с възможност да управляват все по-големи и по-големи модели.

И Hewlett Packard Enterprise пуска своя собствена обществена облачна услуга, захранвана от суперкомпютър, която ще бъде достъпна за предприятия, които искат да обучават генеративни AI модели през втората половина на 2023 г. Подобно на някои от по-новите облачни инфраструктури, тя има предимството, че е специално създаден за широкомащабни случаи на използване на AI, каза Джъстин Хотард, изпълнителен вицепрезидент и генерален мениджър на High Performance Computing, AI & Labs.

Доставчиците на хардуер са съгласни, че все още е рано и че решението в крайна сметка може да бъде хибридно, като някои изчисления се случват в облака, а други на отделни устройства, например.

В дългосрочен план, каза Сустар, причината за съществуването на облака се променя фундаментално от заместител на трудния за поддръжка локален хардуер на компаниите към нещо качествено ново: изчислителна мощност, налична в мащаб, недостъпен досега за предприятията.

„Това наистина е основна промяна по отношение на начина, по който гледаме на инфраструктурата, как проектирахме структурата, как доставяме инфраструктурата“, каза Амин Вахдат, вицепрезидент и генерален мениджър на машинно обучение, системи и облачен AI в Google Cloud.

Още по темата

- 1 В България ще се закриват заводи - няма да останем остров на стабилността

- 2 За социалните мрежи идва "моментът на цигарите“

- 3 Цените на имотите може да се увеличат с до 25% тази година, тъй като има дефицит

- 4 Изпълнителната заповед на Тръмп за душовете включва сериозна изненада

- 5 Примирие между Тръмп и Си изглежда непостижимо, докато Китай се готви за дълга война

Светът е бизнес с Ивайло Лаков /п/

Светът е бизнес с Ивайло Лаков /п/

Виц на деня - 15 април

Виц на деня - 15 април  Мачовете по ТВ днес (15 април)

Мачовете по ТВ днес (15 април)  Хороскоп за 16 април 2025

Хороскоп за 16 април 2025  Без ток във Варна на 15 април 2025

Без ток във Варна на 15 април 2025

Мечките в Белица се събудиха, паркът вече е отворен за посещения

Мечките в Белица се събудиха, паркът вече е отворен за посещения  Зеленски: Русия открито отказва прекратяване на огъня от 34 дни

Зеленски: Русия открито отказва прекратяване на огъня от 34 дни  В Босна и Херцеговина не боядисват, а подковават яйца за Великден

В Босна и Херцеговина не боядисват, а подковават яйца за Великден  Увеличават необходимите години за германски паспорт от 3 на 5

Увеличават необходимите години за германски паспорт от 3 на 5

Легенда ще продължи да рита на "Лаута"

Легенда ще продължи да рита на "Лаута"  В Левски треперят за капитана си

В Левски треперят за капитана си  Еуфория на "Герена": Левски преговаря с нов генерален спонсор

Еуфория на "Герена": Левски преговаря с нов генерален спонсор  Отново ядове за Томаш: Проблемите в ЦСКА нямат край

Отново ядове за Томаш: Проблемите в ЦСКА нямат край

Естонски мотоциклет счупи световния рекорд за пробег

Естонски мотоциклет счупи световния рекорд за пробег  Край с екологията: Америка пак полудя по големите пикапи

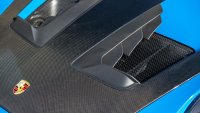

Край с екологията: Америка пак полудя по големите пикапи  Европа забранява и карбона?

Европа забранява и карбона?  "Малката" G-класа на Mercedes ще струва наполовина

"Малката" G-класа на Mercedes ще струва наполовина

дава под наем, Двустаен апартамент, 90 m2 София, Манастирски Ливади, 615 EUR

дава под наем, Двустаен апартамент, 90 m2 София, Манастирски Ливади, 615 EUR  дава под наем, Етаж от къща, 100 m2 София област, Ярема в.з., 350 EUR

дава под наем, Етаж от къща, 100 m2 София област, Ярема в.з., 350 EUR  продава, Двустаен апартамент, 65 m2 София, Люлин 3, 145000 EUR

продава, Двустаен апартамент, 65 m2 София, Люлин 3, 145000 EUR  продава, Тристаен апартамент, 132 m2 Стара Загора, кв. Три Чучура - Север, 112000 EUR

продава, Тристаен апартамент, 132 m2 Стара Загора, кв. Три Чучура - Север, 112000 EUR  дава под наем, Двустаен апартамент, 49 m2 София, Обеля, 450 EUR

дава под наем, Двустаен апартамент, 49 m2 София, Обеля, 450 EUR